Überblick

Virtualisierung ist die Technologie, mit der Sie nützliche IT-Services mithilfe von Ressourcen erstellen können, die traditionell an eine bestimmte Hardware gebunden sind. So sind Sie in der Lage, die vollständige Kapazität einer einzelnen physischen Maschine durch Verteilung ihrer Funktionen auf viele Nutzer oder Umgebungen auszuschöpfen.

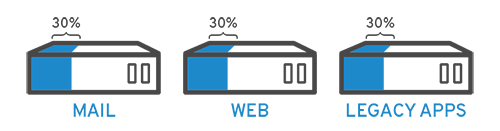

In der Praxis können Sie sich das als drei physische Server mit individuellen Aufgaben vorstellen. Einer ist ein Mailserver, der andere ein Webserver und der dritte führt interne Legacy-Anwendungen aus. Jeder dieser Server wird nur bis zu 30 %, also einem Bruchteil seiner Kapazität genutzt. Da die Legacy-Anwendungen allerdings wichtig für Ihre internen Abläufe sind, müssen Sie diese Systeme sowie den Hostserver behalten, oder?

Früher ja. Da war es oft viel einfacher und zuverlässiger, Aufgaben auf getrennten Servern auszuführen: 1 Server, 1 Betriebssystem, 1 Aufgabe. Ein Server mit mehr als einem Gehirn war nur schwer vorstell- und durchführbar. Durch die Virtualisierung aber können Sie den Mailserver in zwei Maschinen mit unabhängigen Aufgaben aufteilen und die Legacy-Anwendungen so migrieren. Die Hardware bleibt die gleiche, allerdings wird ihre Effizienz um ein Vielfaches gesteigert.

Vor dem Hintergrund des Sicherheitsaspekts könnte man den ersten Server zur Ausführung einer weiteren Aufgabe erneut teilen und damit seine Auslastung von 30 über 60 bis auf 90 % steigern. Die dadurch „leer“ gewordenen Server könnten dann für andere Aufgaben verwendet oder komplett außer Betrieb gesetzt werden, um Kühl- und Wartungskosten einzusparen.

Eine kurze Geschichte der Virtualisierung

Die Anfänge der Virtualisierung lassen sich bis in die 1960er Jahre zurückverfolgen, allerdings wurde die Technologie erst in den frühen 2000ern übernommen. Die Technologien zur Umsetzung der Virtualisierung, wie Hypervisoren, wurden bereits vor Jahrzehnten entwickelt, um mehreren Nutzern gleichzeitig Zugriff auf Computer zur Batch-Verarbeitung zu gewähren. Die Batch-Verarbeitung war damals vor allem in den Geschäftssektoren sehr beliebt, in denen Routineaufgaben tausendfach und extrem schnell durchgeführt werden mussten (wie die Lohnabrechnung).

Im Laufe der folgenden Jahrzehnte aber wurde die Virtualisierung von anderen Lösungen für das Problem „Viele Nutzer/Eine Maschine" überholt. Eine dieser Lösungen war das Timesharing, bei dem Nutzer innerhalb von Betriebssystemen isoliert wurden. Dies wiederum führte fast unbeabsichtigt zu Systemen wie UNIX, auf das dann später Linux® folgte. Während dieser ganzen Zeit führte die Virtualisierung zumeist ein Schattendasein.

Springen wir nun zu den 1990ern. Die meisten Unternehmen verfügten damals über physische Server und IT-Stacks von einzelnen Anbietern, die die Ausführung von Legacy-Apps auf der Hardware eines anderen Anbieters unmöglich machten. Später aktualisierte man dann seine IT-Umgebungen mit kostengünstigeren Commodity-Servern, Betriebssystemen und Anwendungen von einer Vielfalt an Anbietern und machte sich so von ineffizient genutzter Hardware abhängig. So konnte mit jedem Server lediglich eine anbieterspezifische Aufgabe ausgeführt werden.

Und genau da kam die Virtualisierung wieder ins Spiel. Sie präsentierte eine natürliche Lösung für zwei Probleme: Mit ihr konnte man seine Server partitionieren und Legacy-Apps auf mehreren Betriebssystemen und -versionen ausführen. Ganz nebenbei wurden die Server effizienter genutzt (oder gar nicht), was die Kosten in Zusammenhang mit Anschaffung, Einrichtung, Kühlung und Wartung senkte.

Die vielen Einsatzmöglichkeiten der Virtualisierung reduzierten die Anbierterabhängigkeit und bildeten die Grundlage für das Cloud Computing. Mittlerweile ist diese Technologie bei Unternehmen so weit verbreitet, dass man nicht selten eine spezielle Virtualisierungsverwaltungssoftware benötigt, um mit der Entwicklung Schritt halten zu können.

Wie funktioniert Virtualisierung?

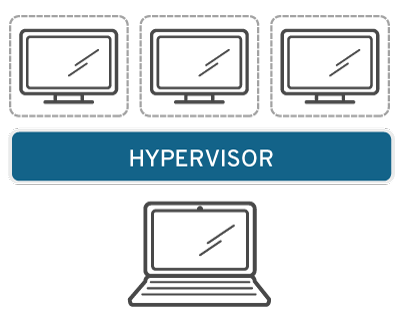

Eine Software namens Hypervisor trennt die physischen Ressourcen von den virtuellen Umgebungen, also den Systemen, die die Ressourcen benötigen. Hypervisoren können auf beliebigen Betriebssystemen aufsitzen (wie auf einem Laptop) oder direkt auf der Hardware (wie ein Server) installiert werden, was das von Unternehmen am häufigsten verwendete Modell ist. Mit Hypervisoren können Sie Ihre physischen Ressourcen zur spezifischen Verwendung durch Ihre virtuellen Umgebungen aufteilen.

Ressourcen werden je nach Bedarf von Ihrer physischen Umgebung an die verschiedenen virtuellen Umgebungen partitioniert. Die Nutzer interagieren mit ihrer speziellen virtuellen Umgebung (normalerweise als Guest oder virtuelle Maschine bezeichnet) und führen dort ihre Berechnungen durch. Die virtuelle Maschine funktioniert wie eine einzelne Datendatei. Und wie diese Dateien auch lassen sie sich von einem PC zum anderen verschieben und dort öffnen bzw. bieten die exakt gleiche Funktion.

Wenn die virtuelle Umgebung ausgeführt wird und ein Nutzer/Programm eine Anweisung ausgibt, die zusätzliche Ressourcen von der physischen Umgebung erfordert, gibt der Hypervisor diese Anfrage an ein physisches System weiter und speichert die Änderungen. Das alles läuft praktisch mit nativer Geschwindigkeit ab (insbesondere, wenn die Anfrage über einen Open Source-Hypervisor gesendet wird, der auf KVM basiert, der Kernel-based Virtual Machine.

Arten der Virtualisierung

Datenvirtualisierung

An vielen Orten verteilte Daten können in einer einzigen Quelle konsolidiert werden. Durch die Virtualisierung von Daten können Unternehmen Daten als dynamische Quelle behandeln. Damit profitieren sie von Verarbeitungsfunktionen, mit denen sie Daten aus mehreren Quellen zusammenführen, neue Datenquellen einfach integrieren und die Daten entsprechend der Nutzeranforderungen umwandeln können. Datenvirtualisierungstools sind mehreren Datenquellen vorgelagert, damit diese als eine Quelle behandelt werden können. So können die benötigen Daten für beliebige Anwendungen oder Nutzer im geforderten Format und zum richtigen Zeitpunkt bereitgestellt werden.

Desktop-Virtualisierung

Die Virtualisierung von Desktops wird oft mit der Virtualisierung von Betriebssystemen verwechselt, die die Ausführung mehrerer Betriebssysteme auf einem Rechner ermöglicht. Mit der Virtualisierung von Desktops allerdings kann ein zentraler Administrator (oder ein automatisiertes Administrationstool) simulierte Desktopumgebungen in Hunderten von physischen Rechnern gleichzeitig simulieren. Im Gegensatz zu traditionellen Desktopumgebungen, die physisch installiert, konfiguriert und für jeden Rechner aktualisiert werden müssen, ermöglicht die Virtualisierung von Desktops dem Administrator die Ausführung von Massenkonfigurationen, Updates und Sicherheitsprüfungen auf allen virtuellen Desktops.

Servervirtualisierung

Server sind Computer, die speziell auf die Verarbeitung eines großen Volumens an spezifischen Aufgaben ausgelegt sind, damit andere Rechner wie Laptops und Desktops für diverse andere Maßnahmen frei bleiben. Durch die Virtualisierung eines Servers lassen sich noch mehr dieser spezifischen Funktionen sowie Partitionierungen ausführen, damit diese Komponenten für mehrere Funktionen verwendet werden können.

Virtualisierung von Betriebssystemen

Die Virtualisierung von Betriebssystemen erfolgt auf Kernelebene, also beim zentralen Task Manager des Betriebssystems. Auf diese Weise können Linux- und Windows-Umgebungen sehr effizient parallel ausgeführt werden. Dazu können Unternehmen virtuelle Betriebssysteme auf Rechnern installieren, was folgende Vorteile bietet:

- Senkung der gesamten Hardware-Kosten, da die Rechner keine anspruchsvollen Out-of-the-Box-Funktionen aufweisen müssen

- Verbesserung der Sicherheit, da alle virtuellen Instanzen überwacht und isoliert werden können

- Reduzierung des Zeitaufwands für IT-Services wie Softwareaktualisierungen

Network Functions Virtualization

Die Network Functions Virtualization (NFV) gewährleistet die Trennung der wichtigsten Netzwerkfunktionen (wie Verzeichnisdienste, gemeinsame Dateinutzung und IP-Konfiguration) zwecks Verteilung über mehrere Umgebungen. Sobald die Softwarefunktionen von den physischen Rechnern „losgelöst" sind, auf denen sie installiert waren, können spezifische Funktionen in einem neuen Netzwerk gepackt und einer speziellen Umgebung zugewiesen werden. Durch die Virtualisierung von Netzwerken lässt sich die Zahl der physischen Komponenten wie Switches, Router, Server, Kabel und Hubs reduzieren, die zur Erstellung von mehreren unabhängigen Netzwerken benötigt werden und besonders in der Telekommunikationsbranche beliebt sind.

Warum Sie Ihre virtuelle Infrastruktur zu Red Hat migrieren sollten

Bei dieser Entscheidung geht es um mehr als Infrastruktur. Es geht darum, auf welche Weise Ihre Infrastruktur die Technologien, die Sie einsetzen möchten, unterstützen kann oder nicht. Eine vertragliche Bindung an Anbieter mit stetig teurer werdenden Lizenzvereinbarungen setzt Ihren Möglichkeiten bei der Investition in moderne Technologien (wie Clouds, Container und Automatisierungssysteme) Grenzen.

Unsere Open Source-Virtualisierungstechnologien sind nicht an solche Lizenzvereinbarungen gebunden. Sie erhalten vollen Zugriff auf den gleichen Quellcode, dem über 90 % aller Fortune 500-Unternehmen vertrauen.* So können Sie ganz nach Belieben eine agile Strategie wählen, eine Hybrid Cloud verwenden oder mit Automatisierungstechnologien experimentieren.

*Red Hat Kundendaten und Liste der Fortune 500, Juni 2018